これは応募いただいたセッションです。

開催されるセッションは後日、参加者の投票を参考に決定されます。

青い薬と赤い薬 : ストリーム処理におけるマトリックス世界

データストリーミング・アプリケーションを設計する際に1つか2つのストリームを扱うことは簡単です。 拡張性と高スループット、耐障害性を提供するものならばどんなストリーミング・フレームワークでも使えるでしょう。

しかし、もしストリームの数が数百や数千にのぼるとき、それらを正しく扱うのは困難な作業です。 どうやって数千ものストリーム間でリソースを共有し、それらを24時間休むことなく走らせ続け、状態を管理し、 高度なストリーミング処理を施し、そしてシステムの再起動をすることなくストリームを追加・削除するのでしょう?

このトークでは数千ものストリームを扱う際によくおこる問題をSpark Structured Streamingをつかってどう解決するかを紹介します。

- トークの長さ

- 40分

- 発表言語

- 英語

- 聴衆の対象

- 中級者: 分野の基礎は分かるが、細かい所は不安

- こんな人におすすめ

- 高スループットなストリーミング分析パイプライン、もしくはそれに類するものを構築したい人々

- 発表者

-

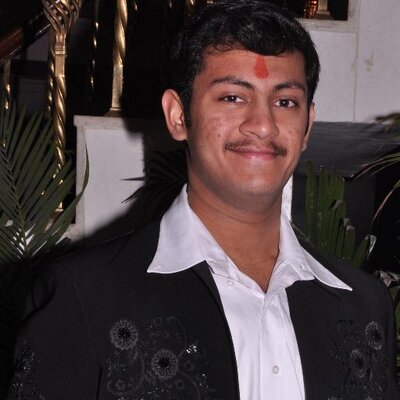

Himanshu Gupta

(Lead Consultant, Knoldus Software LLP)

Himanshu Gupta

(Lead Consultant, Knoldus Software LLP)

票中 票投票済み